人工智能数据中心:2030年电力需求翻倍背后的绿色算力革命

当Open人工智能GPT-4每秒处理超过1亿次推理请求时,当谷歌Depmind的AlphaFold破解了2.3亿个蛋白质结构时,当元宇宙虚拟世界每秒生成50TB数据时,全球人工智能数据中心正在经历一场无声的能源革命,据国际能源署报道(IEA)最新报告,到2030年,全球AI数据中心的电力需求将比2023年增长200%,这一数字不仅反映了算力经济的爆炸性增长,而且揭示了一个被忽视的真相:绿色算力正在重塑全球能源格局。

计算能力飙升:人工智能数据中心为何成为“新石油”?

在硅谷某超级数据中心的地下机房,数万台服务器以惊人的速度吞噬电能。近五年来,全球人工智能培训数据量每3.4个月翻一番,模型参数超过万亿级,推理请求量年均增长300%。这种指数级增长正在改写全球能源领域:

- 特斯拉Dojo超算单芯片功耗比传统架构低100倍,但需要消耗相当于3000户家庭的年用电量

- 微软Azure AI区域为了支持ChatGPT每天10亿次调用,年耗电量相当于瑞士整个用电量

- 中国“东数西算”项目每年减少数据中心碳排放1000多万吨,但计算能力需求仍以40%的增长率吞噬清洁能源

“计算能力就是新石油”的结论正在成为现实。IDC数据显示,2023年全球人工智能数据中心耗电量已占全社会的2.3%,到2030年将超过5%。这种增长不仅来自算法迭代,也来自算法迭代边缘计算的普及、实时人工智能应用爆发(如自动驾驶、工业质量检验)密切相关。

绿色悖论:算力嘉年华与能源转型的角力

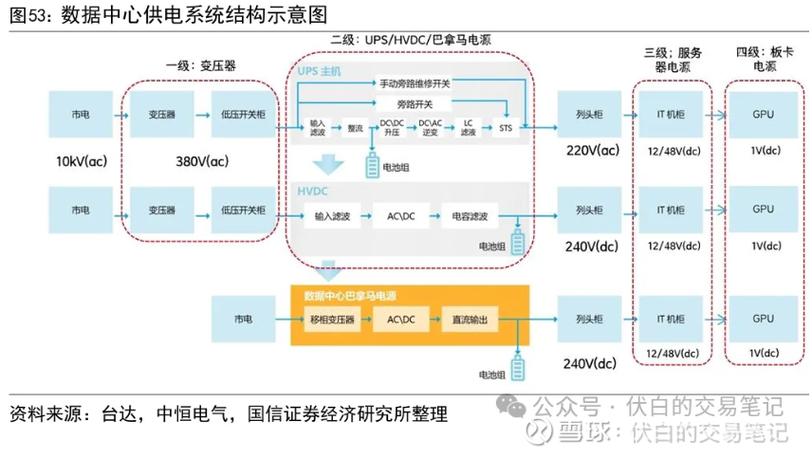

在碳中和目标和人工智能计算能力需求的双重影响下,全球数据中心陷入了“高能耗-高碳足迹”的困境:

- 技术瓶颈:目前,人工智能芯片的能效比(每瓦计算能力)仅为传统CPU的1/10,并面临着“算力墙”效应——当服务器密度超过临界值时,单位计算能耗激增

- 能源结构失衡:全球70%的数据中心仍然依赖煤炭和电力。虽然德国实现了100%的可再生能源供电,但数据中心的用电高峰与风电光伏之间存在致命冲突

- 地理限制:挪威北极圈建成的全球最大数据中心群虽然利用超低温气候降低散热成本,但由于电网稳定性不足,年停机次数超过5000次

这一矛盾催生了一个新的行业命题:如何在这个行业中工作算力密度与碳足迹找到平衡点?

破局之道:从“吃电怪兽”到“绿色引擎”

全球科技巨头正在展开三场关键战役:

- 芯片革命:英伟达H100 GPU能效比突破10000 TFLOPS/W,IBM Condor芯片实现1.2 ExaFLOPS下功耗仅为2.5 MW

- 能源创新:谷歌Deepmind开发了“智能电网预测系统”,将数据中心用电波动与风电预测误差降低40%;中国“光储直柔”技术实现光伏-储能-计算协调调度

- 架构重构:Meta开源”Project Aether单模型训练能耗通过分布式训练降低70%;当华为“盛腾人工智能集群”支持千卡并行时,能效是传统方案的3倍

值得注意的是,虚拟电厂(VPP)该模式正在改写能源游戏规则。德国Enercity公司聚集了5000个数据中心,通过人工智能算法动态调整用电时间,使整体电价降低35%,消耗了当地20%的过剩可再生能源。

未来图:当人工智能遇到碳中和时

到2030年,全球AI数据中心将呈现三大趋势:

- 空间重构:海底数据中心 Natick)采用海水冷却,单设施散热效率提高90%

- 能源互联:欧盟“数字孪生地球”计划实现跨国数据中心计算能力按需分配,减少30%冗余能耗

- 价值闭环:人工智能算法将直接参与电网调度,Open人工智能已测试将部分计算能力资源用于平衡区域电网负荷

麦肯锡的研究表明,如果全球人工智能数据中心的能效提高速度超出预期,到2030年,减少碳排放相当于重建三峡电站,但实现这一愿景需要技术突破、政策指导和资本协调“三螺旋”模式。

当人工智能计算能力成为数字时代的“基础设施”时,其能源需求已经超越了简单的技术问题,演变为全球碳中和过程的战略命题,从芯片设计到电网调度,从数据中心选址到碳交易市场机制,整个产业链正在经历前所未有的重建,绿色计算能力革命不仅与科技公司的竞争力有关,而且定义了人类如何与智能时代共存。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...